Der F1 Score ist eine gängige Bewertungsmetrik, die bei Klassifizierungsaufgaben verwendet wird , um die Genauigkeit des Modells zu messen. Er berücksichtigt sowohl Präzision als auch Rückruf und bietet eine ausgewogene Perspektive auf die Modellleistung.

So funktioniert der F1 Score

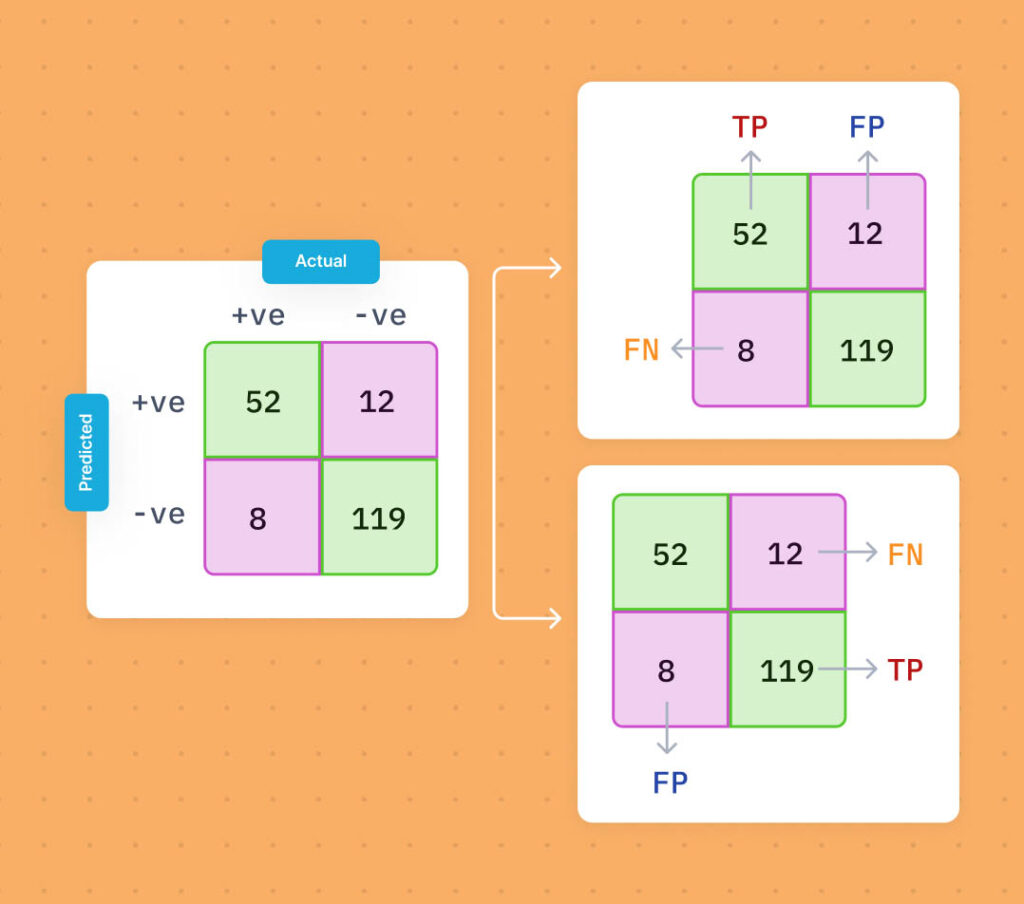

Der F1 Score ist das harmonische Mittel aus Präzision und Rückruf. Präzision ist das Verhältnis von echten positiven Ergebnissen zur Summe der echten positiven und falschen positiven Ergebnisse, während Rückruf das Verhältnis von echten positiven Ergebnissen zur Summe der echten positiven und falschen negativen Ergebnisse ist.

Die Formel für den F1 Score lautet wie folgt:

F1 Score = 2 * (Präzision * Rückruf) / (Präzision + Rückruf)

Warum der F1 Score wichtig ist

Der F1 Score bietet eine einzelne Metrik, die Präzision und Rückruf kombiniert und so eine ganzheitliche Bewertung der Leistung eines Klassifizierungsmodells ermöglicht.

Indem sowohl die Präzision als auch der Rückruf berücksichtigt werden , hilft der F1 Score dabei, Situationen zu erkennen, in denen ein Modell positive Instanzen korrekt identifizieren (Präzision) und gleichzeitig alle positiven Instanzen erfassen kann (Rückruf).

Die Maximierung des F1 Scores bedeutet, das richtige Gleichgewicht zwischen Präzision und Rückruf für ein bestimmtes Klassifizierungsproblem zu finden. Dies ist besonders nützlich, wenn ein Ungleichgewicht in der Klassenverteilung vorliegt.

Die wichtigsten Anwendungsfälle für F1 Scores

- Medizinische Diagnose: Der F1 Score ist bei der medizinischen Diagnose von entscheidender Bedeutung, um einen Kompromiss zwischen der korrekten Diagnose positiver Fälle und der Reduzierung falsch-positiver Fälle zu finden.

- Spam-Filterung: Der F1 Score hilft dabei, die Effektivität von Spam-Filtern bei der korrekten Klassifizierung von Spam-E-Mails zu messen und gleichzeitig Fehlalarme zu minimieren.

- Qualitätskontrolle: Der F1 Score wird verwendet, um die Leistung von Qualitätskontrollmodellen bei der Identifizierung fehlerhafter Produkte bei gleichzeitiger Minimierung falsch-negativer Ergebnisse zu bewerten.

Andere Technologien oder Begriffe im Zusammenhang mit dem F1 Score

Einige verwandte Begriffe sind:

- Präzision: Die Präzision misst die Fähigkeit des Modells, echte positive Ergebnisse korrekt zu identifizieren.

- Rückruf: Der Rückruf misst die Fähigkeit des Modells, alle positiven Instanzen zu erfassen.

- Genauigkeit: Die Genauigkeit misst die allgemeine Richtigkeit der Vorhersagen des Modells.

- Konfusionsmatrix : Eine Konfusionsmatrix bietet eine tabellarische Darstellung der Leistung des Modells durch Vergleich vorhergesagter und tatsächlicher Klassenbezeichnungen.

- AUC-ROC: AUC-ROC (Area Under the Receiver Operating Characteristic Curve) ist eine weitere Bewertungsmetrik, die die Leistung des Modells bei binären Klassifizierungsaufgaben misst.

Warum sich Dremio-Benutzer für den F1 Scores interessieren könnten

Dremio-Benutzer, insbesondere solche, die in der Datenverarbeitung und -analyse tätig sind, können vom Verständnis des F1 Scores profitieren. Durch die Bewertung der Leistung des Modells mithilfe des F1 Scores können Dremio-Benutzer die Genauigkeit ihrer Klassifizierungsmodelle effektiv beurteilen Petabyte-Scale.

Die Möglichkeit, das Gleichgewicht zwischen Präzision und Rückruf zu messen, hilft Benutzern, fundierte Entscheidungen zur Modellverbesserung zu treffen und ihre Datenverarbeitungs-Pipelines für Klassifizierungsaufgaben zu optimieren.